DeepSeek发布开源模型DeepSeek-Coder-V2 在代码和数学能力上超越了GPT-4-Turbo

DeepSeek宣布发布开源模型DeepSeek-Coder-V2

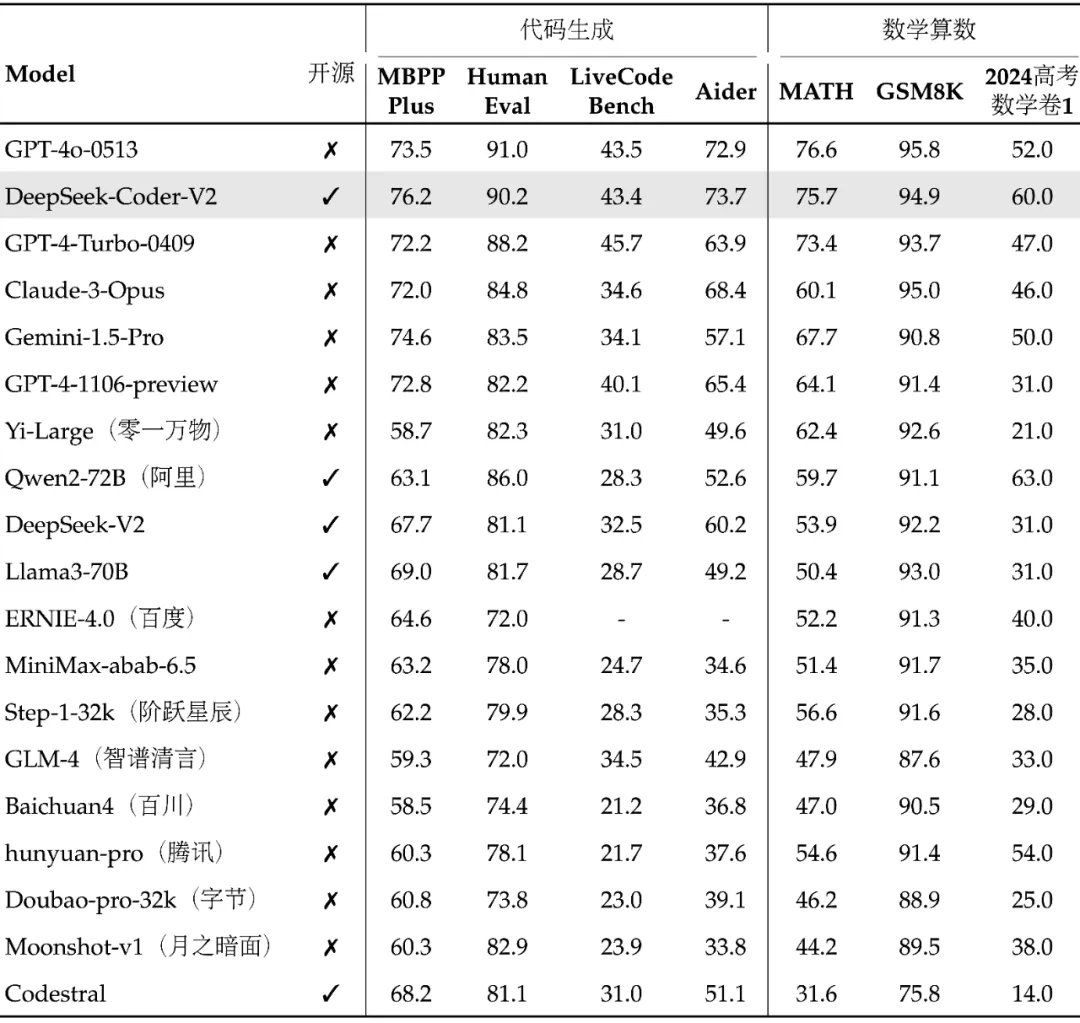

该模型在代码和数学能力上超越了GPT-4-Turbo成为全球首个在这些领域竞争的开源模型。DeepSeek-Coder-V2基于DeepSeek-V2的模型结构,总参数236B,激活参数21B,具有全球顶尖的代码和数学能力,并在多个排行榜上位居全球第二,次于GPT-4o和GPT-4-Turbo之间。同时,它在中英通用能力上也表现出色,位列国内第一梯队。

该模型在代码和数学能力上超越了GPT-4-Turbo成为全球首个在这些领域竞争的开源模型。DeepSeek-Coder-V2基于DeepSeek-V2的模型结构,总参数236B,激活参数21B,具有全球顶尖的代码和数学能力,并在多个排行榜上位居全球第二,次于GPT-4o和GPT-4-Turbo之间。同时,它在中英通用能力上也表现出色,位列国内第一梯队。

DeepSeek-Coder-V2与DeepSeek-V2相比,各有所长,前者更擅长理科,后者更擅长文科。该模型和相关代码、论文全部开源,免费商用,无需申请,提供两种规模:236B和16B,并支持API服务和本地私有化部署。

全球顶尖的代码、数学能力

DeepSeek-Coder-V2 沿用 DeepSeek-V2的模型结构,总参数 236B,激活 21B,在代码、数学的多个榜单上位居全球第二,介于最强闭源模型 GPT-40 和 GPT-4-Turbo 之间。

国内第一梯队的通用能力

国内第一梯队的通用能力

在拥有世界前列的代码、数学能力的同时,DeepSeek-Coder-V2还具有良好的通用性能,在中英通用能力上位列国内第一梯队。

模型架构

DeepSeek-Coder-V2采用专家混合(Mixture-of-Experts,MoE)架构,专门设计用于增强代码和数学推理能力。以下是该模型的一些关键架构特点:

专家混合(MOE)架构:通过多个专家模型的协同工作来处理复杂任务,显著提高了模型的推理能力和效率。

进一步预训练:基于DeepSeek-Coder-V2-Base,从高质量和多源语料库中提取6万亿个token进行预训练,增强了编码和数学推理能力。

多语言支持:支持的编程语言从86种扩展到338种,适应更多样化的开发需求

。扩展上下文长度:支持的上下文长度从16K扩展到128K,能够处理更长的输入内容。

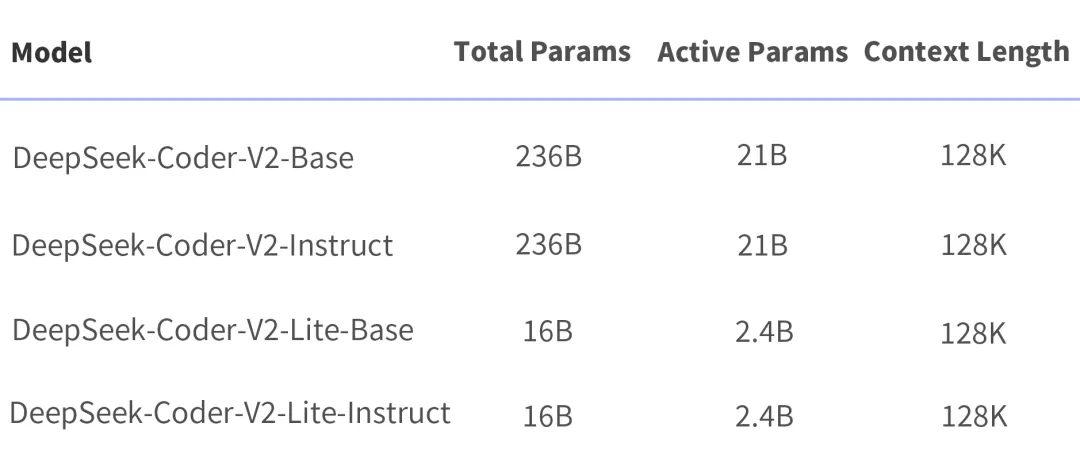

模型规模

DeepSeek-Coder-V2提供了两种规模的模型,分别为236B参数和16B参数,满足不同的应用需求:

DeepSeek-Coder-V2:总参 236B(即官网和 API 版模型),单机 8*80G 可部署,单机 8*80G可微调(需要技巧)

DeepSeek-Coder-V2-Lite:总参16B,激活2.4B,支持 FIM,代码能力接近 DeepSeek-Coder-33B(V1),单卡40G可部署,单机 8*80G可训练。

DeepSeek-Coder-V2和Deepseek-V2 的差异

DeepSeek-Coder-V2和Deepseek-V2 的差异

虽然 DeepSeek-Coder-V2 在评测中综合得分更高,但在实际应用中,两个模型各有所长。DeepSeek-V2 是文科生,DeepSeek-Coder-V2 是理科生,精通的技能点不同:API服务

DeepSeek-Coder-V2 API支持 32K 上下文,价格和 DeepSeek-V2 一致,还是大家熟悉的低价:

评估结果

评估结果

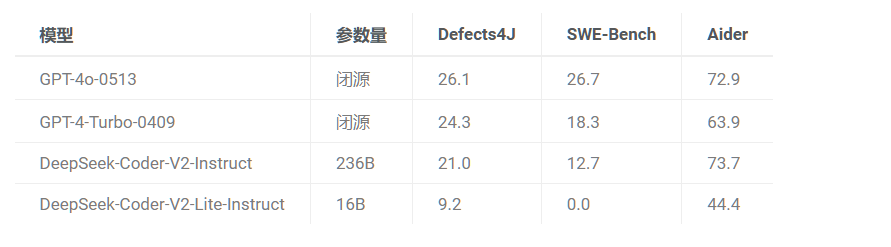

在标准的基准测试中,DeepSeek-Coder-V2的性能优于一些闭源模型,例如GPT4-Turbo、Claude 3Opus和Gemini1.5 Pro,特别是在代码生成和数学推理的测试中。

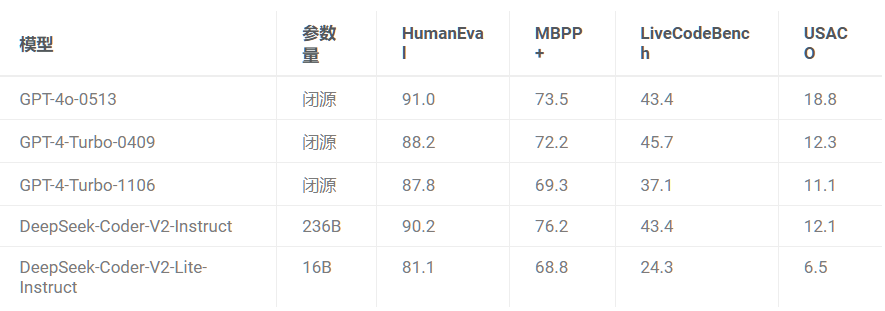

1.代码生成

在多个代码生成基准测试中,DeepSeek-Coder-V2表现优异,特别是在HumanEyal、MBPP+,LiveCodeBench和USACO等测试中,显著超越了许多闭源和开源型。 2.代码补全

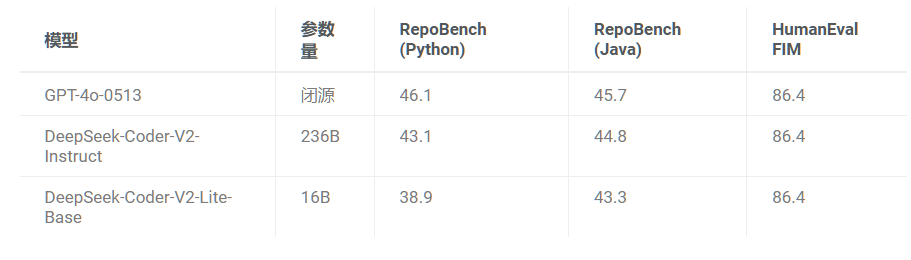

2.代码补全

在RepoBench和HumanEval FIM测试中,DeepSeek-Coder-V2也显示出强大的代码补全能力。 3.代码修复

3.代码修复

在Defects4J和SWE-Bench测试中,DeepSeek-Coder-V2的表现也十分突出。 模型下载:

模型下载:

在线体验: coder.deepseek.com

GitHub:https://github.com/deepseek-ai/DeepSeek-Coder-V2

技术报告:

https://github.com/deepseek-ai/DeepSeek-Coder-V2/blob/main/paper.pdf